Technologie-Peripherieger?te

Technologie-Peripherieger?te

IT Industrie

IT Industrie

Wie optimiert man Einbettungen für einen pr?zisen Abruf?

Wie optimiert man Einbettungen für einen pr?zisen Abruf?

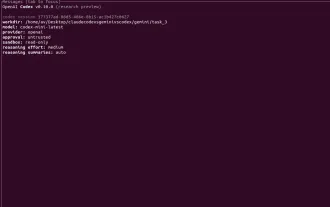

Wie entdecken Maschinen die relevantesten Informationen aus Millionen von Big-Data-Aufzeichnungen? Sie verwenden Einbettungen – Vektoren, die die Bedeutung von Texten, Bildern oder Audiodateien darstellen. Einbettungen erm?glichen es Computern, komplexere Datenformen zu vergleichen und letztendlich zu verstehen, indem sie ihrer Beziehung ein Ma? im mathematischen Raum geben. Aber woher wissen wir, dass Einbettungen zu relevanten Suchergebnissen führen? Die Antwort lautet Optimierung. Die Optimierung der Modelle, die Kuratierung der Daten, die Optimierung von Einbettungen und die Auswahl des richtigen ?hnlichkeitsma?es sind von gro?er Bedeutung. In diesem Artikel werden einige einfache und effektive Techniken zur Optimierung von Einbettungen vorgestellt, um die Abrufgenauigkeit zu verbessern.

Aber bevor wir mit der Optimierung der Einbettung beginnen, wollen wir verstehen, was Einbettung ist und wie der Abruf mithilfe von Einbettung funktioniert.

Inhaltsverzeichnis

- Was sind Einbettungen?

- Optimierung von Einbettungen für einen besseren Abruf

- W?hlen Sie das richtige Einbettungsmodell

- Vorab trainierte vs. benutzerdefinierte Modelle

- Dom?nenspezifische vs. allgemeine Modelle

- Text-, Bild- und multimodale Einbettungen

- Bereinigen und bereiten Sie Ihre Daten vor

- Passen Sie Einbettungen genau an Ihre spezifische Aufgabe an

- W?hlen Sie geeignete ?hnlichkeitsma?e aus

- Einbettungsdimensionalit?t verwalten

- Nutzen Sie effiziente Indexierungs- und Suchalgorithmen

- Bewerten und iterieren

- Erweiterte Optimierungsstrategien

- Abschluss

- H?ufig gestellte Fragen

Was sind Einbettungen?

Durch Einbettungen werden dichte Vektoren mit fester Gr??e erstellt, die Informationen darstellen. Bei den Daten handelt es sich nicht um Rohtext oder Pixel, sondern sie werden im Vektorraum abgebildet. Diese Zuordnung bewahrt semantische Beziehungen und platziert ?hnliche Objekte nahe beieinander. Durch Einbettungen wird auch neuer Text in diesem Bereich dargestellt. Vektoren k?nnen dann mit Ma?en wie der Kosinus?hnlichkeit oder dem euklidischen Abstand verglichen werden. Diese Ma?nahmen quantifizieren die ?hnlichkeit und offenbaren die Bedeutung, die über die Keyword-übereinstimmung hinausgeht.

Weiterlesen: Praktischer Leitfaden zu Word-Einbettungssystemen

Abrufen mithilfe von Einbettungen

Einbettungen sind beim Abruf wichtig, da sowohl die Abfrage als auch die Datenbankelemente als Vektoren dargestellt werden. Das System berechnet die ?hnlichkeit zwischen der Abfrageeinbettung und jedem Kandidatenelement und ordnet die Kandidaten dann nach ?hnlichkeitsbewertung. H?here Werte bedeuten eine st?rkere Relevanz für die Abfrage. Dies ist wichtig, da das System durch Einbettungen semantisch verwandte Ergebnisse finden kann. Sie k?nnen relevante Ergebnisse liefern, selbst wenn W?rter oder Merkmale nicht perfekt übereinstimmen. Dieser flexible Ansatz ruft Elemente auf der Grundlage konzeptioneller ?hnlichkeit und nicht nur symbolischer übereinstimmungen ab.

Optimierung von Einbettungen für einen besseren Abruf

Die Optimierung der Einbettungen ist der Schlüssel zur Verbesserung der Genauigkeit und Effizienz, mit der das System relevante Ergebnisse findet:

W?hlen Sie das richtige Einbettungsmodell

Die Auswahl eines Einbettungsmodells ist ein wichtiger erster Schritt, um genaue Ergebnisse zu erhalten. Einbettungen werden durch Einbettungsmodelle erzeugt – diese Modelle nehmen einfach Rohdaten und wandeln sie in Vektoren um. Allerdings sind nicht alle Einbettungsmodelle für jeden Zweck gut geeignet.

Vorab trainierte vs. benutzerdefinierte Modelle

Es gibt vorab trainierte Modelle, die auf gro?en allgemeinen Datens?tzen trainiert werden. Vorab trainierte Modelle k?nnen Ihnen im Allgemeinen eine gute Basiseinbettung bieten. Ein Beispiel für ein vorab trainiertes Modell w?re BERT für Text oder ResNet für Bilder. Beispiele vorab trainierter Modelle werden uns Zeit und Ressourcen verschaffen, und auch wenn sie schlecht passen, k?nnten sie doch gut passen. Benutzerdefinierte Modelle sind solche, die Sie anhand Ihrer Daten trainiert oder verfeinert haben. Hierbei handelt es sich um bevorzugte Modelle und Rückgabe- oder Berechnungseinbettungen, die speziell auf Ihre Anforderungen zugeschnitten sind, unabh?ngig davon, ob es sich um bestimmte sprachbezogene, umgangssprachliche oder konsistente Muster im Zusammenhang mit Ihrem Anwendungsfall handelt, bei denen die benutzerdefinierten Modelle m?glicherweise bessere Abrufentfernungen erm?glichen.

Dom?nenspezifische vs. allgemeine Modelle

Allgemeine Modelle eignen sich gut für allgemeine Aufgaben, erfassen jedoch oft nicht die Bedeutung im Kontext, die in dom?nenspezifischen Bereichen wie Medizin, Recht oder Finanzen wichtig ist. Dom?nenspezifische Modelle, die auf relevante Korpora trainiert oder verfeinert werden, erfassen die subtilen semantischen Unterschiede und Terminologie in diesen Bereichen, was zu einem genaueren Satz von Einbettungen für Nischenabfrageaufgaben führt.

Text-, Bild- und multimodale Einbettungen

Berücksichtigen Sie bei der Arbeit mit Ihren Daten Modelle, die für Ihren Datentyp optimiert sind. Texteinbettungen (z. B. Satz-BERT) analysieren die semantische Bedeutung in der Sprache. Bildeinbettungen werden von CNN-basierten Modellen durchgeführt und bewerten die visuellen Eigenschaften oder Merkmale in Bildern. Multimodale Modelle (z. B. CLIP) richten Text- und Bildeinbettungen in einem gemeinsamen Raum aus, sodass ein modalübergreifender Abruf m?glich ist. Für einen effizienten Abruf ist daher die Auswahl eines Einbettungsmodells erforderlich, das genau zu Ihrem Datentyp passt.

Bereinigen und bereiten Sie Ihre Daten vor

Die Qualit?t Ihrer Eingabedaten wirkt sich direkt auf die Qualit?t Ihrer Einbettungen und damit Abrufe aus.

- Bedeutung hochwertiger Daten: Die Qualit?t der Eingabedaten ist wirklich wichtig, da Einbettungsmodelle aus den Daten lernen, die sie sehen. Verrauschte Eingabedaten und/oder inkonsistente Daten führen dazu, dass die Einbettungen das Rauschen und die Inkonsistenz widerspiegeln, was sich wahrscheinlich auf die Abrufleistung auswirkt.

- Textnormalisierung und -vorverarbeitung: Die Normalisierung und Vorverarbeitung für Text kann so einfach sein wie das Entfernen aller HTML-Tags und die Kleinschreibung des Textes durch Entfernen aller Sonderzeichen und Konvertieren der Abkürzungen. Dann erleichtern einfache Tokenisierungs- und Lemmatisierungsmethoden den Umgang mit dem Text, indem sie Ihre Daten standardisieren, die Vokabulargr??e reduzieren und die Einbettungen datenübergreifend konsistenter machen.

- Umgang mit Rauschen und Ausrei?ern: Ausrei?er oder fehlerhafte Daten, die für den beabsichtigten Abruf nicht relevant sind, k?nnen die Einbettungsr?ume verzerren. Durch das Herausfiltern fehlerhafter oder themenfremder Daten k?nnen sich die Modelle auf relevante Muster konzentrieren. Bei Bildern führt das Herausfiltern fehlerhafter Bilder oder falscher Beschriftungen zu einer besseren Qualit?t der Einbettungen.

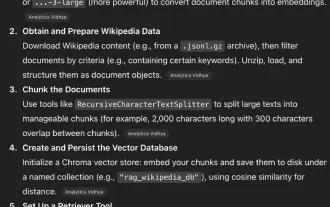

Vergleichen wir nun die Abruf?hnlichkeitswerte einer Beispielabfrage mit Dokumenten in zwei Szenarien:

- Verwendung roher, neugieriger Dokumente : Der Text darin enth?lt HTML-Tags und Sonderzeichen.

- Verwendung eines bereinigten und normalisierten Dokuments : Hier wurden die HTML-Tags mithilfe einer einfachen Funktion bereinigt, um Rauschen zu entfernen und die Formatierung zu standardisieren.

numpy als np importieren

aus sklearn.feature_extraction.text TfidfVectorizer importieren

aus sklearn.metrics.pairwise import cosine_similarity

# Beispieldokumente (eines mit Rauschen)

raw_docs = [

?KI ver?ndert Branchen. Erfahren Sie mehr! ",

?Maschinelles Lernen und KI machen t?glich Fortschritte!“,

?Deep-Learning-Modelle sind gro?artig!!!“,

?Verrauschter Text mit #@! Sonderzeichen und Tippfehler!!“,

?KI/ML ist wichtig für die Gesch?ftsstrategie.“

]

# Textfunktion bereinigen und normalisieren

def clean_text(doc):

Import bzgl

# HTML-Tags entfernen

doc = re.sub(r'<.>', '', doc)

# Kleinbuchstaben

doc = doc.lower()

# Sonderzeichen entfernen

doc = re.sub(r'[^a-z0-9\s]', '', doc)

# Kontraktionen ersetzen – einfaches Beispiel

doc = doc.replace("isn't", "is not")

# Entfernen Sie zus?tzlichen Leerraum

doc = re.sub(r'\s ', ' ', doc).strip()

Rücksendedokument

# Bereinigte Dokumente

clean_docs = [clean_text(d) für d in raw_docs]

# Abfrage

query_raw = ?KI und maschinelles Lernen in der Wirtschaft“

query_clean = clean_text(query_raw)

# Vektorisieren Sie rohe und bereinigte Dokumente

vectorizer_raw = TfidfVectorizer().fit(raw_docs [query_raw])

vectors_raw = vectorizer_raw.transform(raw_docs [query_raw])

vectorizer_clean = TfidfVectorizer().fit(clean_docs [query_clean])

vectors_clean = vectorizer_clean.transform(clean_docs [query_clean])

# Berechnen Sie die ?hnlichkeit für roh und sauber

sim_raw = cosine_similarity(vectors_raw[-1], vectors_raw[:-1]).flatten()

sim_clean = cosine_similarity(vectors_clean[-1], vectors_clean[:-1]).flatten()

print("?hnlichkeitswerte mit RAW-Daten:")

für doc, Ergebnis in zip(raw_docs, sim_raw):

print(f" - {score:.3f} : {doc}") </.>

print("\n?hnlichkeitswerte mit CLEAN-Daten:")

für doc, Ergebnis in zip(clean_docs, sim_clean):

print(f" - {score:.3f} : {doc}")

Aus der Ausgabe k?nnen wir ersehen, dass der ?hnlichkeitswert in den Rohdaten niedriger und weniger konsistent ist, w?hrend sich in den bereinigten Daten der ?hnlichkeitswert für die relevanten Dokumente verbessert hat, was zeigt, wie die Bereinigung dabei hilft, sich auf sinnvolle Muster zu konzentrieren.

Passen Sie Einbettungen genau an Ihre spezifische Aufgabe an

Die vorab trainierten Einbettungen k?nnen so angepasst werden, dass sie besser zu Ihrer Abrufaufgabe passen.

- überwachte Feinabstimmungsans?tze: Modelle werden auf markierten Paaren (Abfrage, relevantes Element) oder Tripletts (Abfrage, relevantes Element, irrelevantes Element) trainiert, um relevante Elemente im Einbettungsraum n?her zusammenzurücken und irrelevante Elemente im Einbettungsraum weiter auseinander zu verschieben. Dieser leistungsorientierte Feinabstimmungsansatz ist nützlich, um die Relevanz Ihrer Abrufaufgabe zu verbessern.

- Kontrastives Lernen und Triplettverlust: Ziel des kontrastiven Verlusts ist es, ?hnliche Paare so nah wie m?glich im Einbettungsraum zu platzieren und gleichzeitig Abstand zu einem un?hnlichen Paar zu halten. Der Triplettverlust ist eine verallgemeinerte Version dieses Prozesses, bei der ein Anker, eine positive und eine negative Stichprobe verwendet werden, um den Einbettungsraum so abzustimmen, dass er für Ihre spezifische Aufgabe diskriminierender wird.

- Hard-Negative-Mining: Hart-negative Proben, bei denen sie den positiven Proben sehr nahe kommen, aber irrelevant sind, zwingen das Modell dazu, feinere Unterscheidungen zu lernen und die Abrufgenauigkeit zu erh?hen.

- Dom?nenanpassung und Datenerweiterung: Die Feinabstimmung aufgaben- oder dom?nenspezifischer Daten umfasst spezifisches Vokabular und Kontexte und hat den Effekt, dass die Einbettung angepasst wird, um diese Zielgruppenkontexte widerzuspiegeln. Datenerweiterungstechniken wie Paraphrasierung, übersetzung von Artikelbeschreibungen oder sogar die synthetische Erstellung von Beispielen verleihen Trainingsdaten eine weitere Dimension und machen sie robuster.

W?hlen Sie geeignete ?hnlichkeitsma?e aus

Das zum Vergleichen von Einbettungen verwendete Ma? gibt Aufschluss über die ?hnlichkeit der Abrufkandidaten.

- Kosinus?hnlichkeit vs. euklidischer Abstand: Die Kosinus?hnlichkeit stellt den Winkel zwischen Vektoren dar und konzentriert sich daher ausschlie?lich auf die Richtung und ignoriert die Gr??e. Daher ist es im Allgemeinen das am h?ufigsten verwendete Ma? für normalisierte Texteinbettungen, da es die semantische ?hnlichkeit genau misst. Andererseits misst die euklidische Distanz die geradlinige Distanz im Vektorraum und ist nützlich für Situationen, in denen die Gr??enunterschiede relevant sind.

- Wann man erlernte ?hnlichkeitsmetriken verwenden sollte: Manchmal ist es wahrscheinlich am besten, ein neuronales Netzwerk zu trainieren, um ?hnlichkeitsfunktionen zu lernen, die für Ihre Daten und Aufgabe geeignet sind. In solchen F?llen werden die erlernten Kennzahlen wahrscheinlich zu beeindruckenden Ergebnissen führen. Diese Methode ist besonders vorteilhaft, da erlernte Metriken in der Lage sind, komplexe Zusammenh?nge zu kapseln und so die Abrufleistung deutlich zu steigern.

Sehen wir uns ein Codebeispiel für Kosinus?hnlichkeit vs. euklidische Distanz an:

numpy als np importieren

aus sklearn.feature_extraction.text TfidfVectorizer importieren

aus sklearn.metrics.pairwise importieren cosine_similarity, euclidean_distances

# Beispieldokumente

Dokumente = [

?KI ver?ndert die Tech-Branche“,

?Maschinelles Lernen bringt KI-Forschung voran“,

?Katzen sind sü?e Tiere“,

]

# Abfrage

query = ?Künstliche Intelligenz und maschinelles Lernen“

# Dokumente vektorisieren und mit TF-IDF abfragen

vectorizer = TfidfVectorizer().fit(docs [query])

doc_vectors = vectorizer.transform(docs)

query_vector = vectorizer.transform([Abfrage])

# Kosinus?hnlichkeit berechnen

cos_sim = cosine_similarity(query_vector, doc_vectors).flatten()

# Berechnen Sie die euklidische Distanz

euc_dist = euclidean_distances(query_vector, doc_vectors).flatten()

# Ergebnisse anzeigen

print("Kosinus-?hnlichkeitswerte:")

für doc, Ergebnis in zip(docs, cos_sim):

print(f"Score: {score:.3f} | Dokument: {doc}")

print("\nEuklidische Distanzwerte:")

für doc, dist in zip(docs, euc_dist):

print(f"Entfernung: {dist:.3f} | Dokument: {doc}")

Anhand beider Ergebnisse k?nnen wir erkennen, dass die Kosinus-?hnlichkeit bei der Erfassung semantischer ?hnlichkeit tendenziell besser ist, wohingegen der euklidische Abstand nützlich sein kann, wenn der absolute Unterschied in der Gr??e von Bedeutung ist.

Einbettungsdimensionalit?t verwalten

Einbettungen unterliegen hinsichtlich der Leistung und des Rechenmanagements den Kosten der Gr??e.

- Ausgewogenheit zwischen Gr??e und Leistung: Gr??ere Einbettungen bieten mehr Darstellungskapazit?t, erfordern jedoch mehr Zeit zum Speichern und Verwenden und erfordern mehr Verarbeitung. Kleinere Einbettungen ben?tigen weniger Zeit für die Nutzung und verringern die Komplexit?t, reale Anwendungen k?nnen jedoch an Nuancen verlieren. Basierend auf den Leistungs- und Geschwindigkeitsanforderungen Ihrer Anwendung müssen Sie m?glicherweise einen Mittelweg finden.

- Techniken und Risiken zur Dimensionsreduktion: Methoden wie PCA oder UMAP k?nnen die Gr??e von Einbettungen minimieren und gleichzeitig die Struktur bewahren. Bei einer zu starken Reduzierung werden jedoch viele semantische Bedeutungsabrufaufgaben entfernt, was die Recherche erheblich beeintr?chtigt. Bewerten Sie die Wirkung immer vor der Anwendung.

Nutzen Sie effiziente Indexierungs- und Suchalgorithmen

Wenn Sie Ihre Suche auf Millionen oder Milliarden von Artikeln skalieren müssen, sind effiziente Suchalgorithmen erforderlich.

- ANN-Methoden (Approximate Nearest Neighbor): Die genaue Skalierung der n?chsten Nachbarn kann kostspielig sein. Daher erm?glichen ANN-Algorithmen eine schnelle N?herungssuche mit geringem Genauigkeitsverlust, was bei der Arbeit mit gro?en Datens?tzen einfacher ist.

- FAISS, Annoy, HNSW übersicht:

- FAISS (Facebook AI Similarity Search) bietet ANN-Suchen mit hohem Durchsatz mit einer GPU und implementiert ein Indexierungsschema, um dies zu erm?glichen.

- Annoy (Approximate Nearest Neighbors Oh Yeah) ist leichtgewichtig und für leseintensive Systeme optimiert.

- HNSW -strukturierte Diagramme (Hierarchical Navigable Small World) liefern zufriedenstellende Ergebnisse für den Abruf und die Suchzeit, indem sie geschichtete Small-World-Diagramme durchqueren.

- Kompromisse zwischen Geschwindigkeit und Genauigkeit: Passen Sie Parameter wie Suchtiefe oder Anzahl der Sonden an, um die Abrufgeschwindigkeit und -genauigkeit basierend auf den spezifischen Anforderungen einer bestimmten Anwendung zu verwalten.

Bewerten und iterieren

Auswertung und Iteration sind wichtig, um den Abruf kontinuierlich zu optimieren.

- Benchmarking mit Standardmetriken: Verwenden Sie Standardmetriken wie Precision@k, Recall@k und Mean Reciprocal Rank (MRR), um die Abrufleistung anhand von Validierungsdatens?tzen quantitativ zu bewerten.

- Fehleranalyse: Denken Sie über die Fehlerf?lle nach, um Muster wie Fehlkategorisierung, Regelm??igkeit oder mehrdeutige Abfragen zu identifizieren. Es hilft bei Datenbereinigungsbemühungen, bei der Optimierung eines Modells oder bei der Absicht, das Training zu verbessern.

- Kontinuierliche Verbesserungsstrategien: Erstellen eines Plans zur kontinuierlichen Verbesserung, der neben dem Lernen auch Benutzerfeedback und Datenaktualisierungen einbezieht. Es gibt neue Trainingsdaten aus Scans, das Umschulen von Modellen mit den neuesten Trainingsdaten und das Testen v?llig unterschiedlicher Architekturen mit Variation von Hyperparametern.

Erweiterte Optimierungsstrategien

Es gibt mehrere fortgeschrittene Strategien, um die Abrufgenauigkeit weiter zu erh?hen.

- Kontextualisierte Einbettungen: Anstatt nur einzelne W?rter einzubetten, sollten Sie die Verwendung von Satz- oder Absatzeinbettungen in Betracht ziehen, die eine umfassendere Bedeutung und einen umfassenderen Kontext widerspiegeln. Wenn Sie Modelle finden, die auch gut funktionieren, wie z. B. Sentence-BERT, erhalten Sie die richtigen Einbettungen.

- Ensemble- und Hybrid-Einbettungen: Kombinieren Sie die Einbettungen aus mehreren Modellen und sogar Datentypen. Sie k?nnten darüber nachdenken, Text- und Bildeinbettungen zu mischen oder verschiedene Modelle zusammen einzubetten. Dadurch k?nnen Sie noch mehr Informationen abrufen.

- Cross-Encoder-Neueinstufung: Mithilfe des Einbettungsabrufs für Erstkandidaten k?nnen Sie als Kandidaten zurückgegebene Bilder nehmen und einen Cross-Encoder verwenden, um eine neue Einstufung gegenüber der Abfrage vorzunehmen, indem Sie die Abfrage und das Element als eine einzige gemeinsame Codierung codieren oder das Modell mehrmals verarbeiten. Dadurch erhalten Sie eine viel pr?zisere Rangfolge, allerdings mit einer l?ngeren Abrufzeit.

- Wissensdestillation: Gro?e Modelle erbringen eine gute Leistung, sind aber beim Abrufen nicht schnell. Sobald Sie Ihr gro?es Modell haben, destillieren Sie dieses Wissen in kleinere Modelle. Mit Ihren kleineren Modellen k?nnen Sie beim Abrufen von Bildern die gleichen Ergebnisse erzielen wie zuvor, jedoch viel schneller und mit einem sehr geringen Genauigkeitsverlust. Das ist gro?artig in der Produktion.

Abschluss

Die Optimierung der Einbettungen erh?ht die Genauigkeit und Geschwindigkeit des Abrufs. W?hlen Sie zun?chst das beste verfügbare Trainingsmodell aus und bereinigen Sie anschlie?end Ihre Daten. W?hlen Sie als N?chstes Ihre Einbettungen aus und optimieren Sie sie. W?hlen Sie dann Ihre ?hnlichkeitsma?e und den bestm?glichen Suchindex aus. Es gibt auch erweiterte Methoden, die Sie anwenden k?nnen, um Ihre Retrieval-Funktion zu verbessern, darunter kontextbezogene Einbettungen, Ensemble-Ans?tze, Re-Ranking und Destillation.

Denken Sie daran, dass die Optimierung nie aufh?rt. Testen, lernen und verbessern Sie Ihr System weiter. Dadurch wird sichergestellt, dass Ihr Abruf im Laufe der Zeit relevant und effektiv bleibt.

H?ufig gestellte Fragen

Q1. Was sind Einbettungen und warum sind sie für den Abruf relevant?A. Einbettungen sind numerische Vektoren, die Daten (z. B. Text, Bilder oder Audio) so darstellen, dass die Semantik erhalten bleibt. Sie bieten ein Distanzma?, um es Maschinen zu erm?glichen, Informationen zu vergleichen und dann schnell zu finden, die für die Einbettung relevant sind. Dies wiederum verbessert das Abrufen.

Q2. Soll ich vorab trainierte Einbettungen verwenden oder meine eigenen trainieren?A. Vorab trainierte Einbettungen funktionieren für die meisten allgemeinen Aufgaben und sparen Zeit. Allerdings ist das Training oder die Feinabstimmung Ihrer Einbettungen anhand Ihrer Daten in der Regel besser und kann immer die Genauigkeit verbessern, insbesondere wenn es sich bei dem Thema um eine Nischendom?ne handelt.

Q3. Was bedeutet Feinabstimmung und wie hilft sie?A. Feinabstimmung bedeutet, ein vorab trainiertes Einbettungsmodell ?anzupassen“. Durch die Feinabstimmung wird das Modell auf der Grundlage einer Reihe aufgabenspezifischer, gekennzeichneter Daten angepasst. Dadurch lernt das Modell die Nuancen dieser Dom?ne und verbessert die Abrufrelevanz.

Das obige ist der detaillierte Inhalt vonWie optimiert man Einbettungen für einen pr?zisen Abruf?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Hei?e KI -Werkzeuge

Undress AI Tool

Ausziehbilder kostenlos

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Stock Market GPT

KI-gestützte Anlageforschung für intelligentere Entscheidungen

Hei?er Artikel

Hei?e Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

KI bedeutet, dass Datenverletzungen jetzt viel weniger kosten - aber sie sind immer noch eine gro?e Bedrohung für Unternehmen

Sep 21, 2025 am 12:24 AM

KI bedeutet, dass Datenverletzungen jetzt viel weniger kosten - aber sie sind immer noch eine gro?e Bedrohung für Unternehmen

Sep 21, 2025 am 12:24 AM

KI verknüpft die Zeit, die für die Erkennung und Reaktion auf Datenverletzungen ben?tigt wird. Berichte von AI-Anwendern sparen bis zu 600.000 GBP pro Versto? im Vergleich zu nicht sanftüber nicht 33% der britischen Organisationen, die KI in ihren Sicherheitsstrategien in den richtigen Erkenntnissen von IBM in umgesetzt haben

Das AI Trust Paradox: Wie regulierte Industrien in einer KI-gesteuerten Welt glaubwürdig bleiben k?nnen

Sep 21, 2025 am 12:36 AM

Das AI Trust Paradox: Wie regulierte Industrien in einer KI-gesteuerten Welt glaubwürdig bleiben k?nnen

Sep 21, 2025 am 12:36 AM

Wenn Sie vor fünf Jahren einen Raum voller risikoaverse Versicherungsmanager mitgeteilt h?tten, dass fast die H?lfte der britischen Verbraucher bald die Gesundheitsberatung von KI begrü?en würden, w?ren Sie mit ernsthafter Skepsis, wenn nicht sogar gelacht.

Codex Cli vs Gemini Cli gegen Claude Code: Welches ist das Beste?

Sep 18, 2025 am 04:06 AM

Codex Cli vs Gemini Cli gegen Claude Code: Welches ist das Beste?

Sep 18, 2025 am 04:06 AM

Im Jahr 2025 wird eine Reihe von AI -Programmierassistenten, auf die direkt vom Terminal aus zugegriffen werden kann, nacheinander freigegeben. Codex CLI, Gemini CLI und Claude Code sind einige dieser beliebten Tools, die gro?e Sprachmodelle in Befehlszeilen -Workflows einbetten. Diese Programmierwerkzeuge k?nnen Code durch natürliche Sprachanweisungen generieren und reparieren und sehr leistungsf?hig sind. Wir haben die Leistung dieser drei Tools in verschiedenen Aufgaben überprüft, um zu bestimmen, welcher praktischer ist. Jeder Assistent basiert auf fortschrittlichen KI-Modellen wie O4-Mini, Gemini 2.5 Pro oder Claude Sonnet 4, die zur Verbesserung der Entwicklungseffizienz entwickelt wurden. Wir setzen die drei in derselben Umgebung und verwenden bestimmte Metriken

GPT 5 gegen GPT 4O: Was ist besser?

Sep 18, 2025 am 03:21 AM

GPT 5 gegen GPT 4O: Was ist besser?

Sep 18, 2025 am 03:21 AM

Die neueste Ver?ffentlichung von GPT-5 hat die Welt im Sturm erobert. Das neueste Flaggschiff -Modell von OpenAI hat gemischte Kritiken erhalten - w?hrend einige seine F?higkeiten loben, andere unterstreichen seine M?ngel. Das hat mich gefragt: Ist gpt-

GCX nennt Luca Simonelli als SVP von Channel und Global Allianzen

Sep 20, 2025 am 02:12 AM

GCX nennt Luca Simonelli als SVP von Channel und Global Allianzen

Sep 20, 2025 am 02:12 AM

GCX Managed Services, ein führender Anbieter von Networking Solutions, hat die Ernennung von Luca Simonelli zum neuen Senior Vice Vice President von Channel und Global Alliances vorgestellt. Diese strategische Einstellung wird als Managed Service Provider - er sichernte Kunde

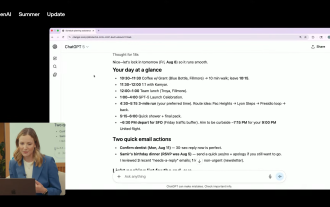

Haben Sie sich jemals gewünscht, dass Chatgpt Ihren Tag planen und Sie an vergessene E -Mails erinnern k?nnte? Sie k?nnen es bald mit Ihrem Google -Konto verknüpfen

Sep 20, 2025 am 12:51 AM

Haben Sie sich jemals gewünscht, dass Chatgpt Ihren Tag planen und Sie an vergessene E -Mails erinnern k?nnte? Sie k?nnen es bald mit Ihrem Google -Konto verknüpfen

Sep 20, 2025 am 12:51 AM

OpenAI hat neben GPT-5 eine wichtige neue Integration vorgestellt, in der Chatgpt Pro-Benutzer ihre Google Mail-, Google-Kalender- und Google-Kontakte direkt an den AI-Assistenten mit Zugriff auf Ihre Google-Apps verbinden k?nnen. ChatGPT kann Ihren Tag zusammenfassen, p generieren.

Wie kann ich über API zu GPT-5 zugreifen?

Sep 25, 2025 am 01:48 AM

Wie kann ich über API zu GPT-5 zugreifen?

Sep 25, 2025 am 01:48 AM

Die jüngste Ver?ffentlichung des GPT-5-Modells bietet Entwicklern innovative KI-Funktionen mit Fortschritten in Codierung, Argumentation und Kreativit?t. Das GPT-5-Modell verfügt über einige neue API-Funktionen, mit denen Sie Ausg?nge erstellen k?nnen, in denen Sie D haben

Identit?tssicherheit ist wichtiger denn je & ndash; Hier ist es, warum

Sep 24, 2025 am 03:48 AM

Identit?tssicherheit ist wichtiger denn je & ndash; Hier ist es, warum

Sep 24, 2025 am 03:48 AM

Wenn KI -Agenten zunehmend verbreitet werden, erkennen die Organisationen an, die entscheidende Rolle der Identit?tssicherheit zu erkennen. Eine jüngste Umfrage von OKTA zeigt, dass 85% der Unternehmen jetzt Identity and Access Management (IAM) berücksichtigen (IAM).