Que faire si l'utilisation de la mémoire redis est trop élevée?

Apr 10, 2025 pm 02:21 PMRedis Memory Soaring comprend: un volume de données trop important, une mauvaise sélection de structure de données, des problèmes de configuration (tels que les paramètres maxmemory trop petits) et des fuites de mémoire. Les solutions incluent: la suppression des données expirées, utiliser la technologie de compression, sélectionner les structures appropriées, ajuster les paramètres de configuration, vérifier les fuites de mémoire dans le code et surveiller régulièrement l'utilisation de la mémoire.

Redis Memory plane? C'est un mal de tête. Après tout, personne ne veut voir leur base de données paralysée en raison d'une mémoire insuffisante. Dans cet article, parlons de ce problème et de certaines des expériences et des le?ons que j'ai apprises au fil des ans. Après l'avoir lu, vous aurez une compréhension plus approfondie de la gestion de la mémoire Redis et pourrez résoudre de nombreux problèmes difficiles.

Parlons d'abord des bases. Redis est une base de données de mémoire qui stocke toutes les données en mémoire à une vitesse très rapide. Mais il n'y a que beaucoup de mémoire, et si vous l'utilisez trop, il explosera naturellement. La manifestation la plus directe de l'utilisation de la mémoire est que Redis est plus lent ou même les temps d'arrêt. Il y a plusieurs raisons derrière cela, nous devons enquêter un par un.

La raison la plus courante est que le volume de données est trop important. Il est naturel que vous ayez trop fourré dans Redis et pas assez de mémoire. La solution est également très directe: supprimer les données! Bien s?r, le mot ?supprimer? est très particulier. Vous pouvez nettoyer régulièrement certaines données expirées ou concevoir des stratégies d'élimination de cache raisonnables basées sur les besoins de l'entreprise, tels que l'algorithme LRU (le moins récemment utilisé).

Une autre raison qui est facilement négligée est la mauvaise sélection des structures de données. Par exemple, si vous utilisez le type de cha?ne pour stocker une grande quantité de données de texte, elle occupera beaucoup de mémoire. Pour le moment, envisagez d'utiliser la technologie de compression ou de choisir une structure plus appropriée, comme une table de collection ou de hachage, ce qui peut réduire efficacement la consommation de mémoire.

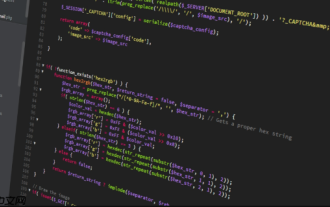

Ci-dessous, je vais vous montrer un exemple pour découvrir les différences de mémoire causées par l'utilisation de différentes structures de données:

<code class="python">import redis r = redis.Redis(host='localhost', port=6379, db=0) # 使用字符串存儲大量文本long_string = "a" * 1024 * 1024 # 1MB 的字符串r.set("long_string", long_string) # 使用列表存儲大量數(shù)據(jù)r.rpush("my_list", *[str(i) for i in range(100000)]) # 查看內(nèi)存使用情況(這部分需要借助Redis的監(jiān)控工具或命令) # ...</code>

Ce code n'est qu'un diagramme. Dans l'application réelle, vous devez sélectionner la structure de données appropriée en fonction de la situation spécifique.

En plus du volume de données et de la structure des données, certains problèmes de configuration peuvent également entra?ner une utilisation excessive de la mémoire. Par exemple, la définition du paramètre maxmemory trop petit, ou le non-réglage de la stratégie d'élimination de la mémoire appropriée entra?nera des problèmes. Vous devez revérifier votre fichier de configuration Redis pour vous assurer que ces paramètres sont correctement définis.

J'ai également vu des fuites de mémoire en raison de bogues de code. Certaines ressources non liées au programme occuperont la mémoire pendant longtemps, ce qui entra?nera finalement une épuisement de la mémoire. Cela vous oblige à vérifier soigneusement le code, à utiliser des outils d'analyse de mémoire et à découvrir la source des fuites de mémoire.

Enfin, n'oubliez pas de surveiller régulièrement l'utilisation de la mémoire de Redis. Vous pouvez utiliser les propres outils de surveillance de Redis ou certains logiciels de surveillance tiers pour découvrir des problèmes en temps opportun et éviter de plus grandes pertes. N'oubliez pas que la prévention est meilleure que le traitement. Développer de bonnes habitudes de code, concevoir rationnellement les stratégies de cache et les surveiller régulièrement pour faire fonctionner votre base de données Redis de manière stable et efficace.

En bref, l'utilisation élevée de la mémoire de Redis est un problème complexe. Vous devez prendre en compte des facteurs tels que le volume de données, la structure des données, les paramètres de configuration et la qualité du code afin de trouver la meilleure solution. J'espère que mon expérience peut vous aider et je vous souhaite une solution réussie à ce problème!

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undress AI Tool

Images de déshabillage gratuites

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

échangez les visages dans n'importe quelle vidéo sans effort grace à notre outil d'échange de visage AI entièrement gratuit?!

Article chaud

Outils chauds

Bloc-notes++7.3.1

éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

PHP appelle AI Intelligent Voice Assistant Assistant PHP Interaction System Construction

Jul 25, 2025 pm 08:45 PM

PHP appelle AI Intelligent Voice Assistant Assistant PHP Interaction System Construction

Jul 25, 2025 pm 08:45 PM

L'entrée vocale de l'utilisateur est capturée et envoyée au backend PHP via l'API MediaRecorder du JavaScript frontal; 2. PHP enregistre l'audio en tant que fichier temporaire et appelle STTAPI (tel que Google ou Baidu Voice Recognition) pour le convertir en texte; 3. PHP envoie le texte à un service d'IA (comme Openaigpt) pour obtenir une réponse intelligente; 4. PHP appelle ensuite TTSAPI (comme Baidu ou Google Voice Synthesis) pour convertir la réponse en fichier vocal; 5. PHP diffuse le fichier vocal vers l'avant pour jouer, terminant l'interaction. L'ensemble du processus est dominé par PHP pour assurer une connexion transparente entre toutes les liens.

Comment utiliser PHP combiné avec l'IA pour obtenir la correction de texte de la syntaxe PHP détection et l'optimisation

Jul 25, 2025 pm 08:57 PM

Comment utiliser PHP combiné avec l'IA pour obtenir la correction de texte de la syntaxe PHP détection et l'optimisation

Jul 25, 2025 pm 08:57 PM

Pour réaliser la correction d'erreur de texte et l'optimisation de la syntaxe avec l'IA, vous devez suivre les étapes suivantes: 1. Sélectionnez un modèle ou une API d'IA appropriée, tels que Baidu, Tencent API ou bibliothèque NLP open source; 2. Appelez l'API via Curl ou Guzzle de PHP et traitez les résultats de retour; 3. Afficher les informations de correction d'erreur dans l'application et permettre aux utilisateurs de choisir d'adopter l'adoption; 4. Utilisez PHP-L et PHP_CODESNIFFER pour la détection de syntaxe et l'optimisation du code; 5. Collectez en continu les commentaires et mettez à jour le modèle ou les règles pour améliorer l'effet. Lorsque vous choisissez AIAPI, concentrez-vous sur l'évaluation de la précision, de la vitesse de réponse, du prix et du support pour PHP. L'optimisation du code doit suivre les spécifications du PSR, utiliser le cache raisonnablement, éviter les requêtes circulaires, revoir le code régulièrement et utiliser x

Python Seaborn JointPlot Exemple

Jul 26, 2025 am 08:11 AM

Python Seaborn JointPlot Exemple

Jul 26, 2025 am 08:11 AM

Utilisez le plot conjoint de Seaborn pour visualiser rapidement la relation et la distribution entre deux variables; 2. Le tracé de diffusion de base est implémenté par sn.jointplot (data = pointes, x = "total_bill", y = "Tip", kind = "dispers"), le centre est un tracé de dispersion et l'histogramme est affiché sur les c?tés supérieur et inférieur et droit; 3. Ajouter des lignes de régression et des informations de densité à un kind = "reg" et combiner marginal_kws pour définir le style de tracé de bord; 4. Lorsque le volume de données est important, il est recommandé d'utiliser "Hex"

Python List to String Conversion Exemple

Jul 26, 2025 am 08:00 AM

Python List to String Conversion Exemple

Jul 26, 2025 am 08:00 AM

Les listes de cha?nes peuvent être fusionnées avec la méthode join (), telles que '' .join (mots) pour obtenir "HelloworldFrompython"; 2. Les listes de nombres doivent être converties en cha?nes avec MAP (STR, nombres) ou [STR (x) Forxinnumbers] avant de rejoindre; 3. Toute liste de types peut être directement convertie en cha?nes avec des supports et des devis, adaptées au débogage; 4. Les formats personnalisés peuvent être implémentés par des expressions de générateur combinées avec join (), telles que '|' .join (f "[{item}]" ForIteminitems)

Comment créer un système de gestion de journaux avec PHP PHP PHP Log Collection and Analysis Tool

Jul 25, 2025 pm 08:48 PM

Comment créer un système de gestion de journaux avec PHP PHP PHP Log Collection and Analysis Tool

Jul 25, 2025 pm 08:48 PM

Sélectionnez la méthode de journalisation: au stade précoce, vous pouvez utiliser l'erreur intégrée_log () pour PHP. Une fois le projet élargi, assurez-vous de passer à des bibliothèques matures telles que Monolog, prendre en charge plusieurs gestionnaires et niveaux de journal et assurez-vous que le journal contient des horodatages, des niveaux, des numéros de ligne de fichiers et des détails d'erreur; 2. Structure de stockage de conception: une petite quantité de journaux peut être stockée dans des fichiers, et s'il existe un grand nombre de journaux, sélectionnez une base de données s'il existe un grand nombre d'analyses. Utilisez MySQL / PostgreSQL sur des données structurées. Elasticsearch Kibana est recommandé pour semi-structuré / non structuré. Dans le même temps, il est formulé pour les stratégies de sauvegarde et de nettoyage régulières; 3. Interface de développement et d'analyse: il devrait avoir des fonctions de recherche, de filtrage, d'agrégation et de visualisation. Il peut être directement intégré à Kibana ou utiliser la bibliothèque du graphique Framework PHP pour développer l'auto-développement, en se concentrant sur la simplicité et la facilité d'interface.

Optimisation de Python pour les opérations liées à la mémoire

Jul 28, 2025 am 03:22 AM

Optimisation de Python pour les opérations liées à la mémoire

Jul 28, 2025 am 03:22 AM

PythonCanBeoptimizedFormemory-Boundoperations AdreductoverHeadHroughGenerators, EfficientDatastructures et ManagingObjectliFetimes.first, useGeneratorsInSteadofListStoproceSlargedataseSeItematatime, EvitingLoadingEnteryToMeToMeMory.

Comment utiliser PHP combiné avec l'IA pour obtenir un résumé automatique. Les longs articles PHP génèrent rapidement un résumé

Jul 25, 2025 pm 08:36 PM

Comment utiliser PHP combiné avec l'IA pour obtenir un résumé automatique. Les longs articles PHP génèrent rapidement un résumé

Jul 25, 2025 pm 08:36 PM

Le c?ur de l'utilisation de PHP pour combiner l'IA pour réaliser un digest automatique est d'appeler les API de services AI, tels que les services NLP à plateforme OpenAI ou Cloud; 2. 3. Le digest peut filtrer efficacement les informations, améliorer la lisibilité, aider à la gestion du contenu et s'adapter à la lecture fragmentée; 4. La sélection d'un modèle nécessite une prise en compte du type abstrait (extrait ou généré), le co?t, la prise en charge du langage, la facilité d'utilisation du document et la sécurité des données; 5. Les défis courants incluent la limitation des taux, le délai d'expiration du réseau, la limite de longueur de texte, le co?t hors de contr?le et les fluctuations de qualité. La stratégie de réponse comprend le mécanisme de réessayer, la file d'attente asynchrone, le traitement des blocs, les résultats du cache et les mots invites d'optimisation.

Python pandas fondre l'exemple

Jul 27, 2025 am 02:48 AM

Python pandas fondre l'exemple

Jul 27, 2025 am 02:48 AM

pandas.melt () est utilisé pour convertir les données de format larges en format long. La réponse consiste à définir de nouveaux noms de colonne en spécifiant id_vars conserver la colonne d'identification, Value_Vars Sélectionnez la colonne à fondre, var_name et valeur_name, 1.id_vars = 'name' signifie que la colonne de nom reste inchangée, 2.Value_vars = [Math ',' English ',' Science '. du nom de colonne d'origine, 4.value_name = 'score' définit le nouveau nom de colonne de la valeur d'origine et génère enfin trois colonnes, notamment le nom, le sujet et le score.