10 meilleurs outils de mise en cache open source pour Linux en 2024

May 26, 2025 am 10:16 AM

Les systèmes et applications informatiques distribués fiables sont devenus la pierre angulaire des entreprises de premier plan, en particulier dans l'automatisation et la gestion des processus commerciaux critiques et la prestation de services aux clients.

En tant que développeurs et administrateurs de systèmes de ces systèmes et applications, vous devez fournir toutes sortes de solutions de technologies de l'information (TI) qui garantiront que vous disposez des systèmes les plus efficaces disponibles.

Cela comprend des taches telles que la conception, les tests et la mise en ?uvre de stratégies pour les performances du système / application, la fiabilité, la disponibilité et l'évolutivité, pour offrir aux utilisateurs finaux un niveau de service satisfaisant.

La mise en cache est l'une des nombreuses techniques de livraison d'applications très basiques mais efficaces sur lesquelles vous pouvez compter. Avant d'aller plus loin, examinons brièvement ce qu'est la mise en cache, où et / ou comment il peut être appliqué et ses avantages.

Table des matières

Qu'est-ce que la mise en cache ou la mise en cache de contenu?

La mise en cache (ou la mise en cache de contenu ) est une technique largement utilisée pour stocker des copies des données dans un emplacement de stockage temporaire (également connu sous le nom de cache ) afin que les données puissent être facilement accessibles et rapidement lorsqu'elles sont récupérées à partir du stockage d'origine.

Les données stockées dans un cache peuvent inclure des fichiers ou des fragments de fichiers (tels que des fichiers HTML, des scripts, des images, des documents, etc.), des opérations ou des enregistrements de base de données, des appels API, des enregistrements DNS, etc. en fonction du type et du but de la mise en cache.

Un cache peut prendre la forme de matériel ou de logiciels. Le cache basé sur le logiciel (qui est au centre de cet article) peut être implémenté dans différentes couches d'une pile d'applications.

La mise en cache peut être appliquée du c?té client (ou sur la couche de présentation de l'application), par exemple, la mise en cache du navigateur ou la mise en cache d'application (ou le mode hors ligne). La plupart sinon tous les navigateurs modernes sont livrés avec une implémentation d'un cache HTTP.

Vous avez peut-être entendu parler de l'expression populaire ? effacer votre cache ? lorsque vous accédez à une application Web pour vous permettre de voir les dernières données ou contenu sur un site Web ou une application, au lieu du navigateur à l'aide d'une ancienne copie du contenu stocké localement.

Un autre exemple de mise en cache c?té client est la mise en cache DNS qui se produit au niveau du système d'exploitation (OS). Il s'agit d'un stockage temporaire d'informations sur les recherches DNS précédentes par le SO ou le navigateur Web.

La mise en cache peut également être mise en ?uvre au niveau du réseau, soit dans un LAN ou WAN via des proxys. Un exemple courant de ce type de mise en cache est dans les CDN ( réseaux de livraison de contenu ), qui sont des réseaux distribués à l'échelle mondiale de serveurs de proxy Web.

Troisièmement, vous pouvez également implémenter la mise en cache au (s) serveur (s) d'origine ou backend. Il existe différentes formes de mise en cache au niveau du serveur, elles incluent:

- Cache de serveur Web (pour la mise en cache d'images, documents, scripts, etc.).

- Cache ou mémorisation d'application (utilisé dans la lecture des fichiers du disque, les données d'autres services ou processus, ou la demande de données auprès d'une API, etc.).

- Cache de base de données (pour fournir un accès en mémoire à des données fréquemment utilisées telles que les lignes de base de données demandées, les résultats de requête et d'autres opérations).

Notez que les données de cache peuvent être stockées dans n'importe quel système de stockage, y compris une base de données, un fichier, une mémoire système, etc., mais doivent être un support plus rapide que la source principale. à cet égard, la mise en cache en mémoire est la forme de mise en cache la plus efficace et couramment utilisée.

Pourquoi utiliser la mise en cache?

La mise en cache offre de nombreux avantages, notamment les suivants:

- Au niveau de la base de données, il améliore les performances de lecture des microsecondes pour les données mises en cache. Vous pouvez également utiliser un cache d'écriture pour améliorer les performances de l'écriture, où les données sont écrites en mémoire et plus tard sur le disque écrit sur disque ou le stockage principal à des intervalles spécifiés. Cependant, l'aspect d'intégrité des données peut avoir des implications potentiellement désastreuses. Par exemple, lorsque le système se bloque juste avant que les données ne soient engagées dans le stockage principal.

- Au niveau de l'application, un cache peut stocker fréquemment des données dans le processus d'application lui-même, réduisant ainsi les temps de recherche de données de quelques secondes aux microsecondes, en particulier sur le réseau.

- Compte tenu des performances globales de l'application et du serveur, la mise en cache aide à réduire la charge du serveur, la latence et la bande passante réseau car les données en cache sont servies aux clients, améliorant ainsi le temps de réponse et les vitesses de livraison aux clients.

- La mise en cache permet également la disponibilité du contenu, en particulier via les CDN et de nombreux autres avantages.

Dans cet article, nous passerons en revue certains des meilleurs outils d'ouverture open-source ( application / base de données et serveurs proxy de mise en cache ) pour implémenter la mise en cache c?té serveur dans Linux.

1. redis

Redis ( Remote Dictionary Server in Full) est un système informatique en mémoire distribué, rapide, rapide, haute performance et flexible qui peut être utilisé à partir de la plupart sinon de tous les langages de programmation.

Il s'agit d'un magasin de structure de données en mémoire qui fonctionne comme un moteur de mise en cache, une base de données sur le disque persistante en mémoire et un courtier de messages. Bien qu'il soit développé et testé sur Linux (la plate-forme recommandée pour le déploiement) et OS X, Redis fonctionne également dans d'autres systèmes POSIX tels que * BSD, sans aucune dépendance externe.

Redis prend en charge de nombreuses structures de données telles que des cha?nes, des hachages, des listes, des ensembles, des ensembles triés, des bitmaps, des flux, etc. Cela permet aux programmeurs d'utiliser une structure de données spécifique pour résoudre un problème spécifique. Il prend en charge les opérations automatiques sur sa structure de données telles que l'ajout d'une cha?ne, poussant les éléments vers une liste, incrément la valeur d'un hachage, l'intersection de l'ensemble informatique, etc.

Ses caractéristiques clés incluent la réplication de Redis Master-Slave (qui est asynchrone par défaut), la haute disponibilité et le basculement automatique offert à l'aide de Redis Sentinel, Redis Cluster (vous pouvez mettre à l'échelle horizontalement en ajoutant plus de n?uds de cluster) et le partitionnement des données (distribution de données entre plusieurs instances Redis). Il propose également la prise en charge des transactions, les scripts LUA, une gamme d'options de persistance et le chiffrement de la communication client-serveur.

étant une base de données sur le disque en mémoire mais persistante, Redis offre les meilleures performances lorsqu'elle fonctionne mieux avec un ensemble de données en mémoire. Cependant, vous pouvez l'utiliser avec une base de données sur le disque telle que MySQL, PostgreSQL et bien d'autres. Par exemple, vous pouvez prendre de petites données très lourdes en écriture dans Redis et laisser d'autres morceaux des données dans une base de données sur le disque.

Redis prend en charge la sécurité à bien des égards: une en utilisant une fonctionnalité ? en mode protégé ? pour sécuriser les instances Redis en étant accessibles à partir de réseaux externes. Il prend également en charge l'authentification client-serveur (lorsqu'un mot de passe est configuré dans le serveur et fourni dans le client) et TLS sur tous les canaux de communication tels que les connexions client, les liens de réplication, le protocole de bus Redis Cluster, etc.

Redis dispose de très nombreux cas d'utilisation qui incluent la mise en cache de la base de données, la mise en cache pleine page, la gestion des données de session utilisateur, le stockage des réponses API, le système de messagerie publié / souscrit, la file d'attente de messages, etc. Ceux-ci peuvent être appliqués dans les jeux, les applications de réseautage social, les flux RSS, l'analyse des données en temps réel, les recommandations d'utilisateurs, etc.

2. Memcached

Memcached est un système de mise en cache d'objet de mémoire distribué libre et open-open, simple mais puissant. Il s'agit d'un magasin de valeurs de clé en mémoire pour de petits morceaux de données tels que les résultats des appels de base de données, des appels API ou un rendu de page. Il fonctionne sur des systèmes d'exploitation de type UNIX, y compris Linux et OS X et également sur Microsoft Windows.

étant un outil de développeur, il est destiné à l'utiliser pour augmenter les vitesses des applications Web dynamiques en mettant en cache du contenu (par défaut, un cache le moins récemment utilisé ( LRU )) réduisant ainsi la charge de base de données sur le disque - il agit comme une mémoire à court terme pour les applications. Il offre une API pour les langages de programmation les plus populaires.

Memcached prend en charge les cha?nes comme le seul type de données. Il a une architecture client-serveur, où la moitié de la logique se produit du c?té client et l'autre moitié du c?té serveur. Surtout, les clients comprennent comment choisir le serveur à rédiger ou à lire, pour un élément. De plus, un client sait très bien quoi faire au cas où il ne peut pas se connecter à un serveur.

Bien qu'il s'agisse d'un système de mise en cache distribué, soutenant ainsi le regroupement, les serveurs Memcached sont déconnectés les uns des autres (c'est-à-dire qu'ils ne sont pas conscients les uns des autres). Cela signifie qu'il n'y a pas de support de réplication comme dans Redis. Ils comprennent également comment stocker et récupérer des articles et gérer quand expulser ou réutiliser la mémoire. Vous pouvez augmenter la mémoire disponible en ajoutant plus de serveurs.

Il prend en charge l'authentification et le cryptage via TLS comme de Memcached 1.5.13, mais cette fonctionnalité est toujours en phase expérimentale.

3. Apache allume

Apache Ignite, est également une boutique de valeurs clés en mémoire distribuée horizontale et open source, un système de base de données multimodel distribué qui fournit des API de traitement puissantes pour le calcul des données distribuées. Il s'agit également d'une grille de données en mémoire qui peut être utilisée soit en mémoire, soit avec une persistance native Ignite. Il fonctionne sur des systèmes de type UNIX tels que Linux et également Windows .

Il dispose de stockage à plusieurs niveaux, de support SQL complet et de transactions acides (atomicité, cohérence, isolement, durabilité) (prise en charge uniquement au niveau de l'API de valeur clé) sur plusieurs n?uds de cluster, le traitement co-localisé et l'apprentissage automatique. Il prend en charge l'intégration automatique avec toutes les bases de données tierces, y compris tous les RDB (tels que MySQL, PostgreSQL, Oracle Database, etc.) ou les magasins NOSQL.

Il est important de noter que même si Ignite fonctionne comme un magasin de données SQL, il ne s'agit pas entièrement d'une base de données SQL. Il gère distinctement les contraintes et les index par rapport aux bases de données traditionnelles; Il prend en charge les index primaires et secondaires, mais seuls les indices primaires sont utilisés pour appliquer l'unicité. En outre, il n'a aucun support pour les contraintes de clés étrangères.

Ignite prend également en charge la sécurité en vous permettant d'activer l'authentification sur le serveur et de fournir des informations d'identification utilisateur aux clients. Il existe également une prise en charge de la communication SSL Socket pour fournir une connexion sécurisée entre tous les n?uds Ignite.

Ignite propose de nombreux cas d'utilisation qui incluent des systèmes de mise en cache, l'accélération de la charge de travail système, le traitement des données en temps réel et l'analyse. Il peut également être utilisé comme plate-forme centrée sur les graphiques.

4. Serveur Couchbase

Le serveur CouchBase est également une base de données d'engagement orientée document open source, distribuée et OSQL qui stocke les données en tant qu'éléments dans un format de valeur clé. Il fonctionne sur Linux et dans d'autres systèmes d'exploitation tels que Windows et Mac OS X. Il utilise un langage de requête axé sur les documents riches en fonctionnalités appelé N1QL qui fournit des services de requête et d'indexation puissants pour prendre en charge les opérations de moins de millisecondes sur les données.

Ses fonctionnalités notables sont un magasin de valeurs de clé rapide avec cache géré, index pour spécialement con?u, un puissant moteur de requête, une architecture d'échelle (échelle multidimensionnelle), Big Data et l'intégration SQL, la sécurité complète et la haute disponibilité.

Le serveur CouchBase est livré avec la prise en charge du cluster de plusieurs instances natives, où un outil de Cluster Manager coordonne toutes les activités de n?ud et fournit simplement une interface à l'échelle du cluster aux clients. Surtout, vous pouvez ajouter, supprimer ou remplacer les n?uds au besoin, sans temps d'arrêt. Il prend également en charge la réplication des données entre les n?uds d'un cluster et la réplication sélective des données entre les centres de données.

Il implémente la sécurité via TLS à l'aide de ports de serveur CouchBase dédiés, différents mécanismes d'authentification (à l'aide d'identification ou de certificats), de contr?le d'accès basé sur les r?les (pour vérifier chaque utilisateur authentifié pour les r?les définis par le système qu'ils sont attribués), l'audit, les journaux et les sessions.

Ses cas d'utilisation incluent une interface de programmation unifiée, une recherche en texte intégral, un traitement parallèle des requêtes, une gestion des documents, une indexation, et bien plus encore, il est spécialement con?u pour fournir une gestion des données de faible latence pour les applications interactives Web, mobiles et IoT à grande échelle.

5. IMDG Hazelcast

Hazelcast IMDG (Grid de données en mémoire) est un middleware de données en mémoire à source ouverte, léger, rapide et extensible, qui fournit un calcul en mémoire distribué élastiquement évolutif. Hazelcast IMDG s'exécute également sur Linux, Windows, Mac OS X et toute autre plate-forme avec Java installée. Il prend en charge une grande variété de structures de données flexibles et linguistiques telles que MAP, Set, List, MultiMap, RingBuffer et Hyperloglog.

Hazelcast est peer-to-peer et prend en charge une évolutivité simple, une configuration de cluster (avec des options pour collecter des statistiques, un surveillant via le protocole JMX et gérer le cluster avec des utilitaires utiles), des structures et événements de données distribués, une réparation de données et des transactions. Il est également redondant car il maintient la sauvegarde de chaque saisie de données sur plusieurs membres. Pour mettre à l'échelle votre cluster, démarrez simplement une autre instance, les données et les sauvegardes sont automatiquement et uniformément équilibrées.

Il fournit une collection d'API utiles pour accéder aux CPU dans votre cluster pour une vitesse de traitement maximale. Il propose également des implémentations distribuées d'un grand nombre d'interfaces adaptées aux développeurs de Java telles que MAP, Fitre, ExecutorService, Lock et JCache.

Ses fonctionnalités de sécurité incluent les membres du cluster et l'authentification des clients et les contr?les de contr?le d'accès sur les opérations du client via les fonctionnalités de sécurité basées sur les JAAS. Il permet également d'intercepter les connexions de socket et les opérations à distance exécutées par les clients, le chiffrement de communication au niveau du socket entre les membres du cluster et l'activation de la communication SSL / TLS. Cependant, selon la documentation officielle, la plupart de ces fonctionnalités de sécurité sont proposées dans la version d'entreprise.

Son cas d'utilisation le plus populaire est la mise en cache en mémoire et le stockage de données distribué. Mais il peut également être déployé pour le clustering de session Web, le remplacement du NOSQL, le traitement parallèle, la messagerie facile et bien plus encore.

6. McROUR

McRouter est un routeur de protocole MEMCached gratuit et open-open pour les déploiements Memcached, développés et entretenus par Facebook . Il dispose d'un protocole ASCII Memcached, d'un routage flexible, d'une prise en charge multi-cluster, de caches à plusieurs niveaux, d'une mise en commun de connexions, de plusieurs schémas de hachage, d'un routage préfixe, de pools répliqués, d'observation du trafic de production, de reconfiguration en ligne et de surveillance de la santé / de basculement de destination.

En outre, il prend en charge l'échauffement de Cold Cache, les statistiques et les commandes de débogage riches, la qualité de service de supprimer fiable, de grandes valeurs et les opérations de diffusion, et est livré avec le support IPv6 et SSL.

Il est utilisé sur Facebook et Instagram en tant que composant central de l'infrastructure de cache, pour traiter près de 5 milliards de demandes par seconde au sommet.

7. Cache de vernis

Varnish Cache est un accélérateur d'application Web flexible, moderne et polyvalent open source qui se trouve entre les clients Web et un serveur d'origine. Il fonctionne sur toutes les plates-formes modernes Linux, FreeBSD et Solaris (x86 uniquement). Il s'agit d'un excellent moteur de mise en cache et accélérateur de contenu que vous pouvez déployer devant un serveur Web tel que Nginx, Apache et bien d'autres, pour écouter le port HTTP par défaut pour recevoir et transférer les demandes des clients au serveur Web et fournir la réponse des serveurs Web au client.

Tout en agissant comme un intermédiaire entre les clients et les serveurs d'origine, Varnish Cache offre plusieurs avantages, l'élément étant en cache du contenu Web en mémoire pour atténuer la charge de votre serveur Web et améliorer les vitesses de livraison aux clients.

Après avoir re?u une demande HTTP à un client, il le transmet au serveur Web backend. Une fois que le serveur Web répond, Varnish cache le contenu en mémoire et fournit la réponse au client. Lorsque le client demande le même contenu, Varnish le servira à partir de la réponse d'application de renforcement du cache. S'il ne peut pas servir le contenu du cache, la demande est transmise au backend et la réponse est mise en cache et livrée au client.

Caractéristiques de vernis VCL ( Langue de configuration de vernis - un langage flexible spécifique au domaine) utilisé pour configurer la fa?on dont les demandes sont traitées et plus, les modules de vernis ( VMOD ) qui sont des extensions pour le cache de vernis.

En termes de sécurité, le cache de vernis prend en charge la journalisation, l'inspection des demandes, la limitation, l'authentification et l'autorisation via des VMOD , mais il manque de prise en charge native pour SSL / TLS. Vous pouvez activer HTTPS pour le cache de vernis à l'aide d'un proxy SSL / TLS tel que Hitch ou Nginx.

Vous pouvez également utiliser Varnish Cache comme pare-feu d'application Web, DDOS Attack Defender, Hotlinking Protector, chargement Balancer, Point d'intégration, passerelle de connexion unique, authentification et mécanisme de politique d'autorisation, correction rapide pour les backends instables et le routeur de demande HTTP.

8. Proxy de mise en cache de calmar

Une autre solution de proxy et de mise en cache libre et open-source, exceptionnelle et largement utilisée pour Linux. Il s'agit d'un logiciel de serveur de cache proxy Web riche en fonctionnalités qui fournit des services de proxy et de cache pour les protocoles réseau populaires, notamment HTTP, HTTPS et FTP. Il fonctionne également sur d'autres plates-formes UNIX et Windows.

Tout comme Varnish Cache , il re?oit les demandes des clients et les transmet aux serveurs backend spécifiés. Lorsque le serveur backend répond, il stocke une copie du contenu dans un cache et la transmet au client. Les demandes futures de même contenu seront servies à partir du cache, ce qui entra?nera une livraison de contenu plus rapide au client. Il optimise donc le flux de données entre le client et le serveur pour améliorer les performances et les caches du contenu fréquemment utilisé pour réduire le trafic réseau et enregistrer la bande passante.

Squid est livré avec des fonctionnalités telles que la distribution de la charge sur les hiérarchies intercommunicantes des serveurs proxy, produisant des données concernant les modèles d'utilisation Web (par exemple, les statistiques sur les sites les plus visitées), vous permet d'analyser, de capturer, de bloquer, de remplacer ou de modifier les messages proxiés.

Il prend également en charge les fonctionnalités de sécurité telles que le contr?le d'accès riche, l'autorisation et l'authentification, le support SSL / TLS et la journalisation des activités.

9. Nginx

Nginx (prononcé en tant que moteur-X ) est une solution consolidée à source ouverte, haute performance, complète et très populaire pour configurer l'infrastructure Web. Il s'agit d'un serveur HTTP, d'un serveur proxy inversé, d'un serveur proxy de courrier et d'un serveur proxy générique TCP / UDP.

Nginx propose des capacités de mise en cache de base où le contenu en cache est stocké dans un cache persistant sur le disque. La partie fascinante de la mise en cache de contenu dans Nginx est qu'elle peut être configurée pour fournir du contenu périmé à partir de son cache lorsqu'il ne peut pas récupérer de contenu frais à partir des serveurs d'origine.

Nginx propose une multitude de fonctionnalités de sécurité pour sécuriser vos systèmes Web, il s'agit notamment de la terminaison SSL, de restriction de l'accès avec l'authentification de base HTTP, de l'authentification basée sur le résultat de la sous-demande, de l'authentification JWT, de la restriction de l'accès aux ressources HTTP proxiées, de la restriction de l'accès par emplacement géographique, et beaucoup plus.

Il est généralement déployé sous forme de proxy inversé, d'équilibreur de chargement, de terminateur SSL / de la passerelle de sécurité, d'accélérateur d'application / cache de contenu et de passerelle API dans une pile d'applications. Il est également utilisé pour les supports en streaming.

10. Serveur de trafic Apache

Enfin et surtout, nous avons Apache Traffic Server, un serveur proxy de mise en cache open-source, rapide, évolutif et extensible avec la prise en charge de HTTP / 1.1 et HTTP / 2.0. Il est con?u pour améliorer l'efficacité du réseau et les performances en mettant en cache le contenu fréquemment accessible au bord d'un réseau, pour les entreprises, les FAI (fournisseurs de serveurs Internet), les fournisseurs d'épinesse, etc.

Il prend en charge la proxyation vers l'avant et l'inverse du trafic HTTP / HTTPS. Il peut également être configuré pour s'exécuter simultanément dans l'un ou les deux modes. Il dispose d'une mise en cache persistante, des API de plugin; Prise en charge de l'ICP (Internet Cache Protocol), ESI (c?té bord comprend); Keep-Alive, et plus encore.

En termes de sécurité, le serveur de trafic prend en charge le contr?le de l'accès des clients en vous permettant de configurer des clients autorisés à utiliser le cache proxy, la terminaison SSL pour les connexions entre les clients et elle-même, et entre elle-même et le serveur d'origine. Il prend également en charge l'authentification et l'autorisation de base via un plugin, la journalisation (de chaque demande qu'il re?oit et chaque erreur qu'il détecte) et la surveillance.

Le serveur de trafic peut être utilisé comme cache proxy Web, proxy vers l'avant, proxy inversé, proxy transparent, équilibreur de charge ou dans une hiérarchie de cache.

Remarques finales

La mise en cache est l'une des technologies de livraison de contenu Web les plus bénéfiques et les plus établies de longue date qui est principalement con?ue pour augmenter la vitesse des sites Web ou des applications. Il aide à réduire la charge du serveur, la latence et la bande passante de votre réseau car les données en cache sont servies aux clients, améliorant ainsi le temps de réponse de l'application et les vitesses de livraison aux clients.

Dans cet article, nous avons passé en revue les meilleurs outils de mise en cache open source à utiliser sur les systèmes Linux. Si vous connaissez d'autres outils de mise en cache open source non répertoriés ici, partagez-les avec nous via le formulaire de rétroaction ci-dessous. Vous pouvez également partager vos réflexions sur cet article avec nous.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undress AI Tool

Images de déshabillage gratuites

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

échangez les visages dans n'importe quelle vidéo sans effort grace à notre outil d'échange de visage AI entièrement gratuit?!

Article chaud

Outils chauds

Bloc-notes++7.3.1

éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Installez LXC (conteneurs Linux) dans Rhel, Rocky et Almalinux

Jul 05, 2025 am 09:25 AM

Installez LXC (conteneurs Linux) dans Rhel, Rocky et Almalinux

Jul 05, 2025 am 09:25 AM

LXD est décrit comme le conteneur de prochaine génération et le gestionnaire de machines virtuelles qui offre un immersif pour les systèmes Linux qui s'exécutent à l'intérieur de conteneurs ou comme machines virtuelles. Il fournit des images pour un nombre démesuré de distributions Linux avec le support

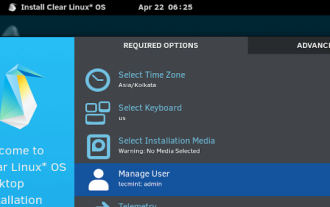

Clear Linux Distro - Optimisé pour les performances et la sécurité

Jul 02, 2025 am 09:49 AM

Clear Linux Distro - Optimisé pour les performances et la sécurité

Jul 02, 2025 am 09:49 AM

Clear Linux OS est le système d'exploitation idéal pour les personnes - les administrateurs du système Ahem - qui veulent avoir une distribution Linux minimale, sécurisée et fiable. Il est optimisé pour l'architecture Intel, ce qui signifie que l'exécution du système d'exploitation linux clair sur AMD SYS

Comment créer un certificat SSL auto-signé à l'aide d'OpenSSL?

Jul 03, 2025 am 12:30 AM

Comment créer un certificat SSL auto-signé à l'aide d'OpenSSL?

Jul 03, 2025 am 12:30 AM

Les étapes clés pour créer un certificat SSL auto-signé sont les suivantes: 1. Générez la clé privée, utilisez la commande OpenSSlGenrsa-OutSelfsigned.key2048 Pour générer un fichier de clé privée RSA 2048 bits, paramètre facultatif -AES256 pour obtenir une protection par mot de passe; 2. Créer une demande de certificat (CSR), exécuter OpenSSLReq-New-KeySelfSigned.Key-OutSelfsigned.csr et remplir les informations pertinentes, en particulier le champ "CommonName"; 3. Générez le certificat par auto-signé et utilisez OpenSSLX509-REQ-DOYS365-Ifelf-Signed.csr-SIGNK

7 fa?ons d'accélérer le navigateur Firefox dans Linux Desktop

Jul 04, 2025 am 09:18 AM

7 fa?ons d'accélérer le navigateur Firefox dans Linux Desktop

Jul 04, 2025 am 09:18 AM

Le navigateur Firefox est le navigateur par défaut pour la plupart des distributions Linux modernes telles que Ubuntu, Mint et Fedora. Initialement, ses performances peuvent être impressionnantes, cependant, avec le temps, vous remarquerez peut-être que votre navigateur n'est pas aussi rapide et res

Comment extraire un fichier .tar.gz ou .zip?

Jul 02, 2025 am 12:52 AM

Comment extraire un fichier .tar.gz ou .zip?

Jul 02, 2025 am 12:52 AM

Décompressez le fichier .zip sur Windows, vous pouvez cliquer avec le bouton droit pour sélectionner "Extraire tout", tandis que le fichier .tar.gz doit utiliser des outils tels que 7-Zip ou Winrar; Sur macOS et Linux, le fichier .zip peut être double-cliqué ou dézip commandé, et le fichier .tar.gz peut être décompressé par la commande TAR ou double-clica directement. Les étapes spécifiques sont: 1. Fichier Windows Processing.zip: clic droit → "Extraire tout"; 2. Fichier Windows Processing.tar.gz: installer des outils tiers → Cliquez avec le bouton droit sur décompresser; 3. Fichier MacOS / Linux Processing.zip: Double-cliquez ou exécutez unzipfilename.zip; 4. MacOS / Linux Processing.TAR

Comment résoudre les problèmes DNS sur une machine Linux?

Jul 07, 2025 am 12:35 AM

Comment résoudre les problèmes DNS sur une machine Linux?

Jul 07, 2025 am 12:35 AM

Lorsque vous rencontrez des problèmes DNS, vérifiez d'abord le fichier /etc/resolv.conf pour voir si le serveur de nom correct est configuré; Deuxièmement, vous pouvez ajouter manuellement le DNS public tel que 8,8.8.8 pour les tests; Utilisez ensuite les commandes NSlookup et Dig pour vérifier si la résolution DNS est normale. Si ces outils ne sont pas installés, vous pouvez d'abord installer le package DnsUtils ou Bind-Utils; Vérifiez ensuite l'état du service et le fichier de configuration résolus SystemD /etc/systemd/resolved.conf, et définissez DNS et FallbackDNS au besoin et redémarrez le service; Enfin, vérifiez l'état de l'interface réseau et les règles du pare-feu, confirmez que le port 53 n'est pas

Installez le guacamole pour l'accès à distance Linux / Windows dans Ubuntu

Jul 08, 2025 am 09:58 AM

Installez le guacamole pour l'accès à distance Linux / Windows dans Ubuntu

Jul 08, 2025 am 09:58 AM

En tant qu'administrateur système, vous pouvez vous retrouver (aujourd'hui ou à l'avenir) dans un environnement où Windows et Linux coexistent. Ce n'est un secret pour personne que certaines grandes entreprises préfèrent (ou doivent) gérer certains de leurs services de production dans Windows Boxes et

Comment débogueriez-vous un serveur lent ou qui a une utilisation élevée de la mémoire?

Jul 06, 2025 am 12:02 AM

Comment débogueriez-vous un serveur lent ou qui a une utilisation élevée de la mémoire?

Jul 06, 2025 am 12:02 AM

Si vous constatez que le serveur s'exécute lentement ou que l'utilisation de la mémoire est trop élevée, vous devez vérifier la cause avant de fonctionner. Tout d'abord, vous devez vérifier l'utilisation des ressources système, utiliser les commandes TOP, HTOP, Free-H, IOSTAT, SS-ANTP et d'autres commandes pour vérifier les connexions CPU, mémoire, E / S de disque et réseau; Deuxièmement, analysez des problèmes de processus spécifiques et suivez le comportement des processus à haute occupation via des outils tels que PS, JSTACK, Strace; puis vérifier les journaux et surveiller les données, afficher les enregistrements OOM, les demandes d'exception, les requêtes lentes et autres indices; Enfin, le traitement ciblé est effectué en fonction de raisons courantes telles que les fuites de mémoire, l'épuisement des pools de connexion, les tempêtes de défaillance du cache et les conflits de taches de synchronisation, optimiser la logique du code, configurer un mécanisme de réessayer du délai de temps, ajouter des fusibles de limite actuelle et les ressources de mesure et d'évaluation régulièrement de la pression et d'évaluation.